Ani fakt, ani fikcja. Dlaczego sondaże mówią nie to, co komentatorzy?

Ani fakt, ani fikcja. Dlaczego sondaże mówią nie to, co komentatorzy?

Jedną z kluczowych kompetencji medialnych jest umiejętność odróżniania fikcji od faktów. Ta tylko pozornie banalna umiejętność wymaga jednak szerokiej wiedzy z wielu dziedzin. Odbiorca mediów powinien mieć w zanadrzu m.in. podstawową wiedzę z zakresu statystyki. Jak zareagować na doniesienie, że partię X od partii Y dzieli w sondażu jeden procent poparcia? Jakie pytania zadać? Jak zinterpretować uzyskane odpowiedzi?

W tym artykule podpowiemy, w jaki sposób analizować informacje o wynikach badań społecznych. Skoncentrujemy się na zagadnieniach związanych z sondażami poparcia dla partii politycznych, choć to tylko drobny ułamek pracy, którą wykonują socjologowie. Opowiemy o wybranych błędach, jakie można popełnić, projektując i realizując badanie, analizując zebrane dane i przedstawiając wyniki. Nasze omówienie jest dalece niewyczerpujące – zwraca jednak uwagę na kilka dobrych nawyków pozwalających krytycznie myśleć o wynikach badań społecznych.

Nieznośna nieuchwytność bytu (społecznego)

Badania społeczne najprawdopodobniej nigdy nie pozwolą na idealne odwzorowanie rzeczywistości. Respondenci zawsze będą o krok przed badaczami: bardziej zmienni, zróżnicowani i mniej chętni do mówienia prawdy, niż chcieliby tego socjologowie. Te i nie tylko te okoliczności powodują, że bardzo trudno powiedzieć, jakie jest zdanie „opinii publicznej”, co faktycznie myślą obywatele i jak popularne są poszczególne poglądy. Omówimy kilka przykładów, które zobrazują, jak bardzo „społeczeństwo” jest „nieuchwytne”.

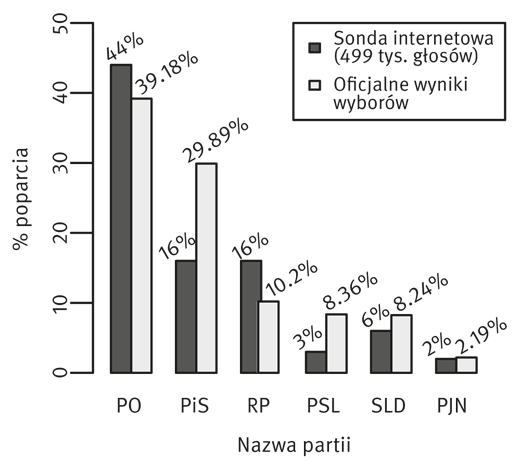

W sondażu internetowym przeprowadzonym po wyborach parlamentarnych w 2011 r. na portalu Onet.pl1 zaobserwowano znaczącą przewagę Platformy Obywatelskiej. W badaniu wzięło udział wiele osób – prawie 500 tys. (dokładnie 499 523). Jednocześnie oficjalne wyniki Państwowej Komisji Wyborczej2 po tych samych wyborach w porównaniu z wynikami sondażu wyglądały następująco:

Wykres 1. Deklarowane poparcie dla partii w wyborach parlamentarnych w 2011 r. – sondaż internetowy na portalu onet.pl oraz oficjalne wyniki Państwowej Komisji Wyborczej – wybory parlamentarne w 2011 r.

Źródło: Onet.wybory. Na którą partię oddałeś/aś głos w wyborach parlamentarnych? 2011, Obwieszczenie PKWKW… 2011.

Jak widać, w ankiecie internetowej PO uzyskała 44%. To wynik prawie trzykrotnie wyższy niż PiS-u i Ruchu Palikota. Faktyczny wynik PO w wyborach parlamentarnych wyniósł 39,2% – był wysoki, ale różnice między partiami wyglądały zupełnie inaczej. Dlaczego sondaż internetowy pokazał wyniki niezgodne z oficjalnymi? Jak wyjaśnić rozbieżności?

Zacznijmy od wielkości próby, czyli tych prawie 500 tys. osób. Warto wyjaśnić, że niemal zawsze w badaniach (poza spisem powszechnym) dobiera się próbę, czyli określoną część większej całości. Badanie całości jest trudne, kosztowne i czasochłonne, a dotychczasowe dokonania statystyki pozwalają nam wyciągać wnioski o populacji na podstawie wybranych jednostek. Na pierwszy rzut oka wydaje się, że liczebności próby nie można nic zarzucić. Łatwo stwierdzić, że im więcej, tym lepiej, czyli im większa próba, tym lepiej sondaż/badania odzwierciedla/ją cechy populacji (czyli wszystkich Polaków). Nic bardziej mylnego.

Po pierwsze – nie tylko wielkość próby się liczy. Ważne jest jeszcze, jak ją dobrano. Jeżeli chcemy uzyskać wyniki reprezentatywne (czyli takie, które pokazują, jak głosowali wszyscy Polacy), powinniśmy dobrać próbę losowo – tak aby każdy Polak/Polka miał/miała jednakową szansę znalezienia się w próbie. Taki dobór wymaga zwykle posiadania listy osób do losowania (operatu losowania). W badaniach w praktyce często taką listą są numery PESEL lub numery telefonów. Dobór spośród nich odbywa się przy użyciu programów komputerowych. W sondażach internetowych głosują ci, którzy korzystają z danej strony, zauważą sondaż i zdecydują się w nim zagłosować. Nie można tego nazwać doborem losowym. W żaden sposób nie kontrolujemy tego, kto bierze udział w badaniu.

Po drugie – wielkość próby jednak się liczy, ale po przekroczeniu pewnego progu jej zwiększanie „nie opłaca się”. Standardowa próba reprezentatywna dla wszystkich Polaków to ok. 1000 osób (z błędem rzędu 3%, ale o tym dalej). Zwróćmy więc uwagę, że te 500 tys. to stanowczo zbyt dużo. Liczba osób, którą musimy przebadać, zależy od wielkości populacji (u nas ok. 38 mln Polaków), a także od przyjętych założeń statystycznych, m.in. tzw. poziomu ufności, czyli dokładności, z jaką chcemy zrealizować badanie.

Po trzecie – próbę bardzo łatwo skrzywić, i to nieświadomie. Internet jest narzędziem pozwalającym w łatwy, szybki i bardzo tani sposób zadać użytkownikom pytania. Ale kluczem jest to, że te pytania zadajemy właśnie internautom. Tymczasem zgodnie z wynikami najnowszej „Diagnozy Społecznej 2013” 75,7% Polaków posiada w domu dostęp do Internetu, z czego 60,8% z niego korzysta3. Pomijanie tak dużej grupy osób, rzędu 30–40%, zakłamuje nasze wyniki. Także dlatego, że dostęp do Internetu rzadziej mają osoby mieszkające na wsi (ze względu na miejsce zamieszkania) czy starsze (ze względu na niższe kompetencje komputerowe), które to osoby jednocześnie mogą reprezentować elektorat określonych partii. Tym samym nasze badanie przeszacowuje wyniki jednych i nie doszacowuje wyników innych partii politycznych, ponieważ nie uwzględnia zjawiska wykluczenia cyfrowego. Podobne problemy mogą wystąpić, gdy korzystamy z badań telefonicznych (brak telefonu) czy ankiet pocztowych (utrudniony dostęp do placówek pocztowych).

Klasycznym przykładem błędnych danych wynikających ze złego doboru próby jest sondaż magazynu informacyjnego „Literary Digest” z 1936 r. Dobór próby oparto na książkach telefonicznych i listach rejestracyjnych samochodów. Do respondentów wysyłano pocztą papierowy kwestionariusz. Wyniki sondażu wskazywały na przegraną Roosevelta (43%), podczas gdy w rzeczywistych wyborach uzyskał największą w historii przewagę głosów nad kontrkandydatem (61% poparcia). Tak znaczący błąd wynikał właśnie z doboru próby – w sondażu wzięło udział zbyt wiele osób zamożnych, czyli posiadających samochód lub telefon4.

W badaniach poparcia politycznego (i nie tylko), oprócz doboru próby, liczą się również sposób konstrukcji narzędzia badawczego (lista pytań) i sytuacja badawcza (tu szczególnie tzw. efekt ankieterski).

Zacznijmy od konstrukcji narzędzia. Za dość powszechne można uznać przekonanie, że stworzenie pytań to nic trudnego. Problem pojawia się wtedy, gdy sami zaczynamy zastanawiać się, jak zapytać respondentów o to, co nas interesuje, jak zrobić to rzetelnie, niesugerująco i trafnie. Jednym z wielu dylematów jest wybór między pytaniami zamkniętymi i otwartymi, czyli między takimi, które mają listę sugerowanych odpowiedzi, i takimi, w przypadku których respondent posiłkuje się wyłącznie własną pamięcią. Bardzo wyraźnie widać efekt takich zabiegów, gdy co jakiś czas w mediach pojawiają się „szokujące” informacje o wysokim poparciu dla kandydatów, których nikt wcześniej nie brał pod uwagę. Zwykle to poparcie wynika z faktu, że w sugerowanych odpowiedziach, i to na jednej z pierwszych pozycji, podano nazwisko tegoż kandydata. Z kolei w przypadku pytań otwartych zdarza się, że badani deklarują chęć głosowania na nieistniejące partie.

W kontekście pytań sugerujących warto przywołać przykład niedawnego (lipiec 2013) sondażu Homo Homini, w którym stowarzyszenie „Republikanie” uzyskało aż 19% poparcia5. Taki wynik czynił ze stowarzyszenia trzecią siłę polityczną w Polsce. Okazało się, że był to efekt usytuowania pytań o poparcie polityczne w kwestionariuszu. Agencje badawcze regularnie przeprowadzają tzw. badania omnibusowe, zawierające wiele pytań z różnych dziedzin. Klienci mogą zamówić umieszczenie swoich pytań w takim omnibusie. Tak też zrobiło stowarzyszenie „Republikanie”.

Pytanie o preferencje wyborcze poprzedzone było pytaniami na temat wysokości podatków, funkcjonowania ZUS-u, kwestii demograficznych, negatywnych opinii o PO i PiS, a także pytaniem o rozpoznawanie stowarzyszenia, które brzmiało następująco: Czy słyszał(a) Pan(i) o powstaniu nowego stowarzyszenia „Republikanie”, założonego przez posła Przemysława Wiplera, którego programem jest m.in. obniżenie podatków, ograniczenie obciążeń biurokratycznych, zmniejszenie liczby urzędników oraz wsparcie dla rodzin?6

Nietrudno zauważyć ścisły związek między wcześniejszymi pytaniami a skrótowo pisanym programem stowarzyszenia. To typowy przykład wyników zaburzonych pytaniami sugerującymi, który wyjaśnia aż 19-procentowe poparcie dla stowarzyszenia „Republikanie”.

Wśród istotnych czynników wpływających na wyniki sondaży znajduje się też efekt ankieterski, czyli to, jak na odpowiedzi badanych wpływa sama rozmowa z ankieterem – osobą o określonych poglądach, wyglądzie, wieku, płci, statusie ekonomicznym itp. Respondenci mają tendencję do dopasowywania odpowiedzi do wyobrażonych oczekiwań ankietera. Z kolei ankieterzy mogą swoje sympatie i antypatie polityczne wyrażać zupełnie nieświadomie. Ta wiedza jest ważna, gdy bierzemy pod uwagę szczególnie partie reprezentujące skrajne stanowisko albo takie, które są źle kojarzone. Respondenci mogą nie przyznawać się do poparcia partii niepopularnych w mediach głównego nurtu – najpoczytniejszych czy najczęściej oglądanych.

Takie są fakty. Mniej więcej. I na 95%

Warto również zastanowić się, co to tak naprawdę znaczy, że poparcie dla danej partii wynosi ileś procent, a różnica poparcia między partiami to jeden czy dwa punkty procentowe. To zagadnienie omówimy na przykładzie artykułu z portalu www.rmf24.pl. Tekst z kwietnia br. nosi tytuł „PiS goni w sondażu PO, dzieli je zaledwie 1 procent”. Autor artykułu powołuje się na wyniki sondażu TNS Polska, zleconego przez TVP Info. Poparcie dla PO wynosiło 34%, a dla PiS 33%. Badanie przeprowadzono w dniach 10–11 kwietnia na 1000-osobowej reprezentatywnej próbie dorosłych Polaków7.

Taki wynik można skomentować następująco: poparcie dla PO jest wyższe niż dla PiS. Powyższy prosty wniosek jest jednak nieprecyzyjny. Dlaczego? Ze względu na tzw. błąd statystyczny z próby.

Idea błędu statystycznego jest bardzo prosta. Skoro dobieramy z populacji (wszystkich Polaków) próbę (zwykle 1000 osób), to z pewnością popełnimy jakiś błąd. Niewielki, ale zawsze. Ten błąd to właśnie błąd statystyczny z próby. Błąd statystyczny z próby określa, z jak wysokim prawdopodobieństwem (poziom ufności badania) odsetek z próby nie będzie się różnił od odsetka w populacji o więcej niż przyjęty błąd statystyczny8. Przy próbie 1000 osób standardowy błąd to 3%. Zwykle przyjmuje się też poziom ufności na poziomie 0,95. Jeżeli chcemy określić wahania poparcia dla danej partii, od podawanego w mediach wyniku powinniśmy odjąć i dodać 3%9. To oznacza, że rzeczywiste poparcie dla PO waha się między 31% a 37%.

Spróbujmy przełożyć definicję na powyższy przykład. Z prawdopodobieństwem 95% poparcie dla PO w wysokości 34% różni się od rzeczywistego poparcia o nie więcej niż 3%. Czyli przedział od 31% do 37% „pokrywa” rzeczywiste poparcie (którego nie znamy, jeśli nie przebadamy dokładnie wszystkich Polaków) z prawdopodobieństwem 95%. Dla PiS przedział wygląda następująco: 30–36%.

W praktyce nie trzeba pamiętać dość skomplikowanej definicji – wystarczy dodawać i odejmować 3%. Przy czym warto mieć na uwadze, że to może być więcej niż 3% – takie dane powinny się pojawiać przy wynikach sondaży obok m.in. wielkości próby, metody czy okresu przeprowadzania badania.

Skoro poparcie wszystkich partii nie jest punktem, ale pewnym przedziałem, to również mówienie o różnicach między partiami oraz o trendach zmian w poparciu partii powinno być dużo bardziej ostrożne. W naszym przykładzie różnica między PO (34%) a PiS (33%) nie wynosi po prostu 1 punkt procentowy, ale może wynosić aż 7 punktów procentowych (37% dla PO, 30% dla PiS). W rzeczywistości poparcie dla tych partii może być identyczne – może wynosić 31%, 32%, 33%, 34%, 35% lub 36%. Może być też tak, że to PiS wygrywa z PO. Jak widać, przedział ufności czyni interpretację danych dużo bardziej wieloznaczną niż ta powszechna w mediach.

Dla partii o poparciu oscylującym w granicach progu wyborczego (5%) idea błędu statystycznego z próby jest szczególnie istotna. Ma on szczególne znaczenie, gdyw wynikach sondaży dwie partie mają poparcie 5% (przedział 2–8%) i 7% (przedział 4–10%). Można sobie wyobrazić sytuację, że obie partie nie pojawią się w sejmie (jedna może mieć poparcie 2%, a druga 4%), i taką, w której obie będą w sejmie reprezentowane (jedna może mieć poparcie 8%, a druga 10%), i to z niezłym wynikiem wyborczym.

Dlatego też ważne jest uwzględnianie w przedstawianych w mediach wynikach badań nie tylko partii, które przekroczyły 5% poparcia (przedział od 2% do 8%) – co jest częstą praktyką. Dolnym progiem przy błędzie 3% powinno być poparcie rzędu 2%, bo przedział poparcia sięga tych pięciu granicznych procent.

Zagubione w interpretacji

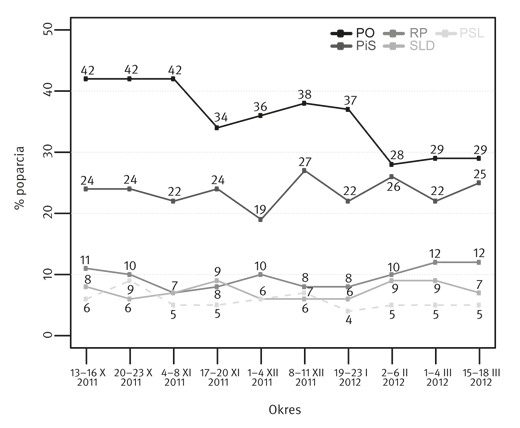

Poniższy wykres przedstawia zmiany poparcia dla partii politycznych (PO, PiS, RP, SLD i PSL) w okresie od października 2011 do marca 2012 r. Badanie na zlecenie „Gazety Wyborczej” przeprowadził TNS OBOP.

Wykres 2. Zmiana poparcia dla partii politycznych w okresie X 2011 – III 2012

Źródło: Kolejny sondaż potwierdza trend: Prawo i Sprawiedliwość powoli dogania Platformę, 2012. Portal wpolityce.pl za gazeta.pl

Autorzy omówienia na portalu wpolityce.pl na podstawie danych wyciągnęli następujący wniosek: Kolejny sondaż potwierdza trend: Prawo i Sprawiedliwość powoli dogania Platformę10. I rzeczywiście, patrząc na wykres, można odnieść takie wrażenie. Różnica poparcia między partiami wyraźnie się zmniejsza. Warto jednak dokładniej przyjrzeć się poziomym liniom na wykresie odwołującym się do pionowej skali. Poparcie dla PiS w wymienionym okresie wahało się między 19 a 27%, ale na początku i końcu porównywanego okresu było prawie takie samo (24% i 25%). Poparcie PO zwykle było stabilne lub spadało – tak że różnica między początkiem okresu (42%) a końcem (29%) wyniosła 13 punktów procentowych. Tym samym jeżeli możemy mówić o jakiejś zmianie, to nie o „doganianiu” w wykonaniu PiS, a raczej o „zwalnianiu” czy traceniu poparcia przez PO.

Ten przykład ma za zadanie uwypuklić, jak ważne jest samodzielne interpretowanie danych i niepodążanie za podanymi w tekstach wnioskami. Warto pamiętać, że wiedza dziennikarzy w zakresie interpretacji danych statystycznych może być porównywalna z naszą.

Zastanówmy się więc nad rolą, jaką pełnią sondaże w przestrzeni publicznej. Poza podstawową funkcją – dostarczania informacji o opinii społeczeństwa na jakiś ważny temat – sondaże często są narzędziem manipulacji opinią publiczną. To, z czym stykamy się za pośrednictwem radia, prasy, telewizji czy Internetu, to najczęściej suche dane wyrwane z kontekstu albo zniekształcone informacje opatrzone tendencyjną interpretacją wyników sondaży. Posługując się jednak wynikami sondaży dotyczących np. potencjalnych zachowań wyborców, stwarza się wrażenie, że przewidywania oparte są na faktach i naukowych narzędziach, zasługując tym samym na uwagę11.

Zdarza się, że w tym samym tygodniu media przytaczają wyniki badań różnych ośrodków, podając inne dane procentowe dotyczące opinii społecznych o bardzo zbliżonych kwestiach. Odbiorca może stracić orientację, co oznaczają podawane zestawienia procentowe. Stąd też częściej opieramy się na komentarzach i interpretacjach sondaży niż na ich wynikach. Zauważmy, jak informacja pochodząca z sondażu staje się przedmiotem manipulacji i gry między różnymi interesariuszami. Takim interesariuszem, który jest manipulowany przez „producentów” i „sprzedawców” informacji, jesteśmy także my – odbiorcy treści publikowanych w mediach. Mechanizm działania sondażu jako narzędzia manipulacji wyjaśnia pojęcie spirali milczenia (ang. spiral of silence), stworzone przez Elisabeth Noelle-Neumann, niemiecką badaczkę opinii publicznej. Pojęcie odnosi się do zachowań osób, które biorąc udział w badaniach opinii publicznej, ukrywają swoje poglądy. Wynika to z przeświadczenia o ich niezgodności z opinią ogółu społeczeństwa, wywołującego u tych osób poczucie dysonansu i niedopasowania. Skąd bierze się w nas takie przeświadczenie? Właśnie z obserwacji przekazu, który dominuje w mediach czy dyskusjach w naszym najbliższym otoczeniu. W przypadku gdy w mediach zaczyna dominować poparcie dla partii X, część osób będzie ukrywać swoje poglądy w obawie przed krytyką społeczną. W konsekwencji część z tych osób będzie, wbrew swoim przekonaniom, deklarowała w sondażach poparcie dla partii, której obecnie poparcie społeczne rośnie. Im więcej osób ukrywa faktyczną opinię, tym bardziej zaczyna dominować opinia domniemanej większości, a spirala cały czas się nakręca. Zazwyczaj moment wyborów przerywa nakręcającą się spiralę, gdy głosujący mogą wyrazić swoje rzeczywiste poparcie w pełni anonimowo12.

Z tego właśnie względu „produkowanie” sondaży po prostu się opłaca: politykom w kreacji wizerunków i pozyskiwaniu poparcia; mediom, które dzięki „kliknięciom” zwiększają swoją oglądalność; ośrodkom badawczym, które na przeprowadzaniu sondaży zarabiają. Taka sytuacja prowadzi do wielu nadużyć już na poziomie samego przeprowadzania sondażu przez firmy badawcze. Zdarza się, że realizują one badanie w taki sposób, że wyniki z góry mają wprowadzać w błąd. Zamiast pytać tylko osoby zdecydowane, czyli takie, które wiedzą, że będą głosować, i wiedzą, na kogo, pytania zadaje się wszystkim dostępnym respondentom. Ci ostatni zwykle wskazują jakiekolwiek nazwisko spośród sugerowanych im osób. W takim, częstym niestety, przypadku mamy do czynienia z fikcyjnymi, a nie faktycznymi deklaracjami13.

Fatamorgana. Ile mirażu na wykresie?

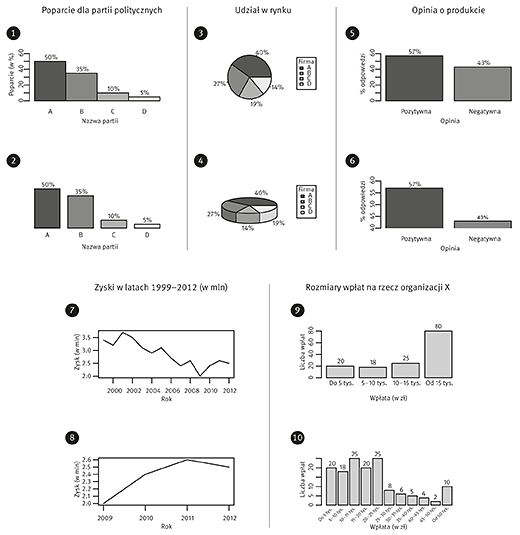

Nawet najlepiej przeprowadzone badanie można źle zinterpretować lub przedstawić. Przykład złej interpretacji zaprezentowaliśmy, wspominając o partii, która rzekomo doganiała drugą partię, podczas gdy to poparcie drugiej partii spadało, a pierwszej zmieniało się w granicach błędu statystycznego, czyli de facto stało w miejscu. Teraz pokażemy pięć przykładów, kiedy konstrukcja wykresu może wpłynąć na postrzeganie wyników przez odbiorcę. W przypadku pierwszych czterech par wykres u góry uważamy za bardziej rzetelny niż ten na dole. Ostatni przykład jest trudniejszy i nie podejmujemy się oceny, który z dwóch wykresów jest lepszy. Pozostawiamy to jako ćwiczenie intelektualne dla czytelnika. Czy obraz prezentowany na wykresie wyglądałby inaczej, gdybyśmy zastosowali inne szerokości przedziałów? Czy gdybyśmy zastosowali inny typ wykresu, moglibyśmy lepiej odzwierciedlić dane na wykresie? A teraz przejdźmy do omówienia poszczególnych par wykresów.

Para 1.–2. Dość powszechną praktyką w prezentowaniu wyników sondaży wyborczych jest pomijanie osi Y (pionowej). Utrudnia to ocenę, czy wysokość poszczególnych słupków odzwierciedla wartości prezentowane nad słupkami. Wadliwe pod tym względem wykresy prezentowano w polskich mediach – zarówno w prasie, jak i w telewizji. Brak osi Y na wykresie drugim powoduje, że trudniej dostrzec nieproporcjonalnie wysoki słupek prezentujący wynik partii „B”. Choć poparcie tej partii wynosi 35%, słupek sięga do wysokości 41 punktów procentowych. Dodatkowo porównywanie wysokości słupków jest utrudnione poprzez zastosowanie odstępów między słupkami. To również powszechna praktyka w prezentowaniu wyników sondaży wyborczych.

Para 3.–4. Stosowanie wykresów trójwymiarowych, zwłaszcza kołowych, umożliwia manipulowanie widoczną powierzchnią poszczególnych wycinków. Na wykresie czwartym najmniejszy wycinek (14%) został zaprezentowany frontalnie. Dzięki temu widać całą ścianę boczną tego wycinka, powiększoną dodatkowo poprzez zwiększenie wysokości wykresu. Zniekształcenie perspektywiczne powoduje, że szczególnie różnica między wycinkiem 14% a 19% wydaje się mniejsza, niż jest w rzeczywistości.

Para 5.–6. Obydwa wykresy prezentują dokładnie te same dane liczbowe. Wnioski płynące z tych wykresów są zatem jednakowe. Ich czysto wizualna interpretacja kazałaby jednak zakładać, że wykres szósty prezentuje sytuację, w której produkt otrzymywał więcej pozytywnych opinii, a wykres piąty – mniej. Ten efekt osiągnięto, ustawiając na wykresie szóstym minimalną wartość osi Y na 40%. Zabieg ten spowodował, że ukryta została część wykresu wskazująca na podobieństwo między opiniami, a podkreślona została ta jego część, która skupia uwagę na różnicy między opiniami pozytywnymi a negatywnymi.

Para 7.–8. Poza pytaniem, czy dane zaprezentowano prawidłowo, należy postawić sobie również pytanie o to, czy zaprezentowano wszystkie dostępne dane. Interpretacja wzrostu zysków zaprezentowanego na wykresie ósmym zmienia się, jeśli spojrzymy na szerszy kontekst historyczny przedstawiony na wykresie siódmym. Okazuje się bowiem, że rok 2009 nie jest punktem startowym, lecz rokiem najniższych zysków firmy, poprzedzonym prawie dekadą spadków.

Para 9.-10. Na wykresach dziewiątym i dziesiątym przedstawiono te same dane. Różnią się one jednak liczbą przedziałów. Wizualna interpretacja wykresu dziewiątego wskazywałaby, że najczęściej na rzecz organizacji X wpłacano duże kwoty pieniędzy (powyżej 15 tys. zł). Z kolei wizualna interpretacja wykresu dziesiątego sugeruje, że częściej dokonywano wpłat mniejszych. Poza liczbą przedziałów zmianie podlegać mogą także ich zakresy. Jak zmieni się postać wykresu, jeśli zwiększymy szerokość przedziału do 10 tys. zł lub zmniejszymy do 2,5 tysiąca? Czy zastosowanie innego typu wykresu – np. wykresu skrzynkowego – dałoby lepszy wgląd w dane?

Podsumowanie

Zmiana obecnej sytuacji w obszarze manipulacji sondażami, tak jak wiele zmian społecznych, nie musi zachodzić od razu w sposób systemowy. Zdarza się, że jest wynikiem samoorganizacji obywateli. Ciekawym przykładem takiej inicjatywy są działania zespołu projektowego „Na Straży Sondaży”, który monitoruje jakość prowadzonych w naszym kraju sondaży oraz sposoby ich omawiania w mediach.

W wielu krajach funkcjonują również stowarzyszenia branżowe określające normy prowadzonych badań i monitorujące pracę ośrodków badawczych. W Polsce w 1997 r. została powołana Organizacja Firm Badania Opinii i Rynku (OFBOR), której celem jest kontrola przestrzegania norm etycznych oraz metodologicznych w badaniach opinii i rynku, a także działanie na rzecz publicznego zaufania do badań14. Na stronie internetowej OFBOR możemy zapoznać się z „Przewodnikiem ESOMAR/WOPR – sondaże opinii publicznej i publikowanie wyników badań”15, który w szczegółowy sposób omawia metodologiczne kwestie dotyczące poprawnej realizacji sondaży. Określa też wymogi dotyczące publikacji w mediach. Praktyki OFBOR, skupiającej 21 wiodących agencji badawczych w Polsce, niestety rzadko przekładają się na faktyczne działania firm badawczych i ośrodków medialnych, które nadal nie zawsze stosują się do zaleceń formułowanych przez OFBOR.

Podobne działania monitorujące możemy także podejmować na mniejszą skalę sami. Podsumujmy zatem to, na co należy zwracać uwagę podczas czytania wyników sondaży, aby nie dać się zmanipulować. Przede wszystkim musimy zwrócić uwagę na podstawowe informacje, które są podawane (powinniśmy raczej napisać „powinny być podawane”) obok publikowanych wyników:

Nazwa wykonawcy – chociaż nie zawsze wykonanie badania przez bardziej znaną firmę jest gwarancją jego rzetelności, to jednak ta informacja pozwala nam rozeznać się w pewnych standardach stosowanych przez poszczególne ośrodki badawcze i poznać źródło prezentowanych wyników.

Data realizacji badania – musimy pamiętać, że nagłe wydarzenia mogą w znaczącym stopniu wpływać na opinie badanych, np. decyzje polityków mogą powodować słabnięcie ich poparcia społecznego w określonych środowiskach.

Określenie badanej populacji i próby badawczej – wiemy już, że nie wielkość próby się liczy, a raczej stosunek jej wielkości do całej populacji badanych osób oraz sposób jej doboru. Warto mieć też na uwadze, że nie wszystkie sondaże przeprowadzane są na próbie ogólnopolskiej, w której grupę badanych osób dobieramy na podstawie liczby i cech społeczno-demograficznych wszystkich Polaków.

Metoda doboru próby – zwróćmy uwagę, czy próbę dobrano w sposób losowy, czyli tak, że każdy z tym samym prawdopodobieństwem może zostać „wybrany” do udziału w sondażu, czy w jakiś inny sposób. Tutaj powinna się również znaleźć informacja, czy próba ma charakter reprezentatywny.

Metoda zbierania danych – sposób zbierania danych w dużym stopniu określa, kto udziela odpowiedzi. Szczególnie trzeba zwracać uwagę na sondaże internetowe, w których w znacznym stopniu nie biorą udziału osoby starsze czy mieszkające na wsi lub z dochodami znacznie niższymi niż przeciętne. Dane możemy zbierać np. w trakcie bezpośredniej rozmowy z badanym face to face (badania typu PAPI), przeprowadzając wywiady telefoniczne (badanie typu CATI) czy rozsyłając badanym formularz elektronicznej ankiety do samodzielnego wypełnienia (badanie CAWI). Z dużym prawdopodobieństwem możemy powiedzieć, że za każdym razem, stosując inną metodę zbierania danych, trafimy na innych respondentów.

Odsetek oraz sposób postępowania z respondentami odmawiającymi odpowiedzi – jest to informacja o tzw. realizacji próby, czyli liczbie osób, które faktycznie odpowiedziały na pytania sondażu z naszej grupy badanych. Znaczący odsetek odmów może mocno zaburzyć wynik sondażu. Z problemem odmów brania udziału w badaniach albo niechęci odpowiadania na poszczególne pytania spotykamy się najczęściej wtedy, gdy badanie dotyczy tematów osobistych i drażliwych dla respondentów.

Treść pytania sondażu – sami możemy dzięki temu rozstrzygnąć, czy pytanie w jakiś sposób sugerowało odpowiedź badanym.

Informacja o wielkość błędu statystycznego, np. dla wyników poparcia każdego z prezentowanych kandydatów lub partii – pozwala nam samym określić przedział poparcia dla każdej z partii i oszacować jego rzeczywisty poziom.

Sposób prezentacji danych – jesteśmy wzrokowcami i to, co jest ładnie podkreślone, uwypuklone czy kolorowe, łatwiej rzuca nam się w oczy, a my łatwiej zapamiętujemy tak zaprezentowaną informację. Pamiętajmy o sposobach manipulacji na graficznie przedstawianych wynikach sondażu i wczytajmy się w nie.

Teraz, gdy jesteśmy wyposażeni w pewną wiedzę dotyczącą sondaży i zdemaskowaliśmy niektóre z mechanizmów manipulacji ich wynikami (nie rozstrzygamy, kiedy mamy do czynienia z intencjonalną manipulacją, a kiedy z nieumiejętnym zastosowaniem narzędzi lub z niezrozumieniem, jak narzędzia te działają), nie pozostaje nam nic innego, jak rozwijać swoją wrażliwość na informacje, które do nas docierają. Czasem zdarza się, że jeden wykres przedstawiający wyniki sondażu potrafi dostarczyć więcej informacji niż cała burza medialna i komentarze, które toczą się wokół jego wyników. Ale z drugiej strony jeden sondaż może być obciążony całym mnóstwem błędów na wszystkich etapach badania, poczynając od jego zaprojektowania, poprzez etap realizacji i analizy wyników, a na prezentacji w mediach kończąc. Aby być wnikliwym obserwatorem sfery publicznej, powinniśmy z przymrużeniem oka traktować wyniki pojedynczych sondaży i ich porównania z dwóch okresów, a brać pod uwagę raczej średnie z wielu sondaży, mówiące o pewnym stałym trendzie. Pozostaje nam samym dbać o przekaz, który do nas dociera, gdyż wydaje się, że w najbliższym czasie nie można liczyć na sondażową rewolucję ośrodków badawczych, mediów czy polityków.

Autorzy są członkami Zespołu Realizacji Badań Instytutu Socjologii Uniwersytetu Mikołaja Kopernika „Pryzmat”

Przypisy:

- Zob.: Onet.wybory. Na którą partię oddałeś/aś głos w wyborach parlamentarnych?, 2011, http://wybory.onet.pl/parlamentarne-2011/index.html, dostęp: 12.07.2013.

- Obwieszczenie Państwowej Komisji Wyborczej z dnia 11 października 2011 r. o wynikach wyborów do Sejmu Rzeczypospolitej Polskiej przeprowadzonych w dniu 9 października 2011 r. (Dz. U. Z dnia 12 października 2011 r. Nr 218, poz. 1294), Wyciąg. 2011, http://pkw.gov.pl/g2/2011_10/445f624b1f6fbcca94c9761c5fac9f1a.pdf, dostęp: 12.07.2013.

- Diagnoza społeczna 2013. Raport (wstępny) Prezentacja Dominika Batorskiego (slajd nr 13), 2013, http://www.diagnoza.com/, dostęp: 12.07.2013.

- E. Babbie, Badania społeczne w praktyce, Warszawa 2004, s. 202.

- Homo Homini tłumaczy się z 19 proc. dla Wiplera, 2013, http://www.wprost.pl/ar/406828/, dostęp: 12.07.2013.

- Badanie dla Stowarzyszenia „Republikanie”, 2013, http://www.homohomini.com.pl/news/130/55/Badanie-dla-Stowarzyszenia-Republikanie/d,Aktualno%C5%9Bci/, dostęp: 12.07.2013.

- PiS goni w sondażu PO, dzieli je zaledwie 1 procent, 2013, http://www.rmf24.pl/fakty/polska/news-pis-goni-w-sondazu-po-dzieli-je-zaledwie-1-procent,nId,955041, dostęp: 12.07.2013.

- Błąd statystyczny i przedział ufności, 2013, http://nastrazysondazy.uw.edu.pl/metodologia/blad-statystyczny/, dostęp: 12.07.2013.

- Bardzo ważne: wartość błędu powinna być każdorazowo podawana przy wynikach sondaży, tak aby umożliwić czytelnikom oszacowanie przedziału poparcia. Prawie nigdy takich informacji nie ma. W przytaczanym artykule również się nie pojawiły. Błąd 3% jest wartością standardową, ale w każdym badaniu może mieć różną wielkość, np. 5%.

- Kolejny sondaż potwierdza trend: Prawo i Sprawiedliwość powoli dogania Platformę, 2012, http://wpolityce.pl/wydarzenia/25257-kolejny-sondaz-potwierdza-trend-prawo-i-sprawiedliwosc-powoli-dogania-platforme, dostęp: 12.07.2013.

- R. Dyoniziak, Sondaże a manipulowanie społeczeństwem, Kraków 1997, ss. 2–9.

- E. Noelle-Neumann, Spirala milczenia: opinia publiczna – nasza skóra społeczna, Poznań 2004, ss. 22–25.

- R. Dyonizak, op. cit.

- Organizacja, 2013, http://ofbor.pl/organizacja/, dostęp: 12.07.2013.

- Przewodnik ESOMAR/WOPR – Sondaże opinii publicznej i publikowanie wyników badań, 2011, http://www.ofbor.pl/public/File/OFBOR_ESOMAR-WAPOR%20Guide_PL11_08_01.pdf, dostęp: 12.07.2013.

Patronite

Patronite